今年の年末商戦では、Snapdragon X Elite、Ryzen AI 300シリーズ、Core Ultra 200Vシリーズなど、Microsoftの提唱するCopilot+PCを満たす商品が全面的にプッシュされそうです。

しかしこのCopilot+PCには様々な疑問が付きまといます。前回のAI解説記事でもお話しした通り、現在NPUで実行できるアプリはほとんどないのにCopilot+PCという名前だけが先走りしている感があります。AIと言えばGPUで、NVIDIAが大変人気で実用例も多いという話は聞いたことがあると思います。GPUを積んでいてもCopilot+PCになれないのは不可思議な話です。また昨年からIntel、AMDとも”AI PC”として10 TOPS程度のNPUを搭載した製品を発売してきましたが、それらはCopilot+PCにはならないようです。今回はこういった疑問について少し答えを探していきたいと思います。

GPUの性能が高ければCopilot+PCにならないの?

ニューラルネットワークは、従来GPUを使って行われ、AIブームに乗って大企業が争ってGPUを買う状況が続いてきました。しかし、Copilot+PCでは「40 TOPS 以上の処理能率を持つNPU」が条件で、GPUは外されています。これはGPUではできないのでしょうか?

今まで報じられているところによると、MicrosoftがCopilotのAIプログラムをGeForce上で動かす仕組みを作っているという話はあります。2024年内はできてベータ版とされているので、完成は早くて2025年になるのではないかと思います。ただCopilot+PCはNPU基準だけが先行してアプリが付いてくるのが数年後という流れになっており、2025年末に対応したとしても実用的には全然間に合っていると感じるのではないでしょうか。

仮にGPUでOKになったとして、どの程度の機種から行けるでしょうか?

NVIDIA製品の場合、AI処理のTensor Coreが入ったのがRTX 2000シリーズ以降なので、少なくともそれ以降の世代になるでしょう(もっと絞って今年発売中の世代あたりに限られる可能性はあります)。高性能計算機専門の企業のカタログによると、デスクトップ用GeForceビデオカードのINT8でのTOPS数は、RTX3080が238(疎高速化476)、RTX3070が163(疎高速化325)、RTX3060が95(疎高速化191)となっており、いずれもCopilot+PC基準の40 TOPSを大きく超えます。一般化すればGeForce RTXのTOPS値はTime Spy Graphicsスコアの0.0125倍(疎高速化可なら0.025倍)と概算でき、Time Spyスコアが7000点あれば40 TOPS基準は満たせるだろうと思われます(例えばRTX4060搭載の1.5 kgノートなら余裕でしょう)。

ノートPCの場合は電力設定によって実速度が変わるため、かつてのWindows Experience IndexのようにOSがその場でベンチマークを取って可否を判断するのか、「RTX4050はOK」などのように機種名でいくのか、そのあたりの基準はまだ決まっていないのではないかと思います。

それ以外の他社については現状GPU対応の話は聞こえませんが、Lunar lakeの発表会では、内蔵GPUでも67 TOPSは出せるとしており(ただしXMXとDP4aの合算でXMXのみではこれより遅いと考えられ、実際ULのベンチマークではNPUのほうが若干早い模様)、OpenVINOの汎用性から考えるとIntelは対応しに行ってデスクトップ用Arcでの対応を狙うかもしれません。Meteor lakeやArrow lakeの内蔵GPUはXMX非搭載なので難しいでしょう。

なぜNPUが必要なの?

MicrosoftはCopilot+PCの条件としてNPUだけを提示していますが、AIはNPUでないと計算できないのでしょうか?本質的にはノーです。現代のCPUはなんでも計算できるのでNPUに計算できることも計算できます。ニューラルネットワークはNPUという概念が生まれる前からGPUで学習と推論の両方をやっており、(VRAM容量等のハードウェア制限を除けば)原則論としてはNPUにできることはGPUにもできます。

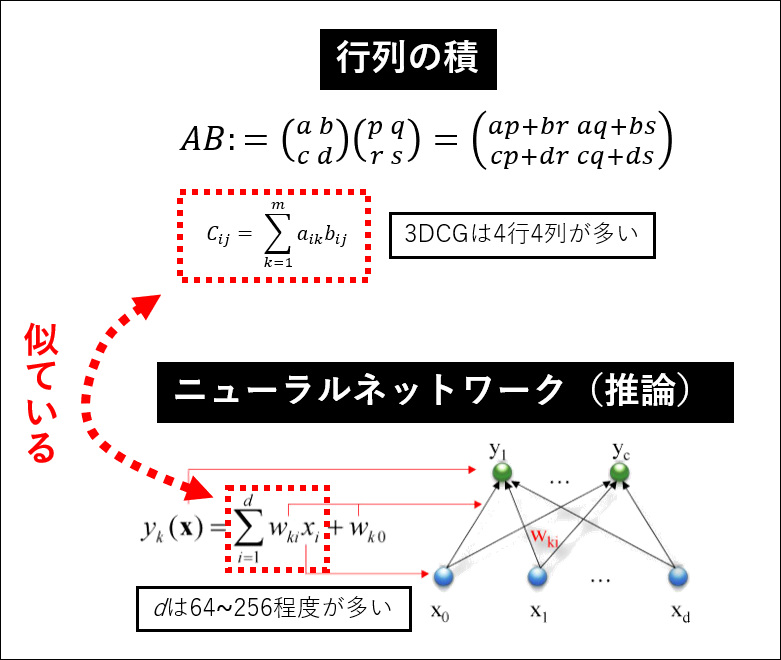

ではNPUは何のためにあるのでしょうか?NPUとは「ニューラルネットワークの、それも推論向き(消費者向け)で学習を考慮しない設計とする代わり、電力効率が高く小型・安価に作れる」ということを志向した製品です。例えばMeteor lakeの発表会ではNPUのAI電力効率はGPUの7.8倍と紹介されました(ただしGPU側にXMXなし)。ニューラルネットワークの計算をGPUで行うのは、もともとGPGPU(GPUによる汎用計算)という概念が先にあり、3DCGの計算における行列の積とNN計算が共通して積和演算を多用するため相性が良かったためですが、一方でGPUはあくまで3DCG用で、AI演算だけを考えるとレイトレーシングなどの回路は不要で無駄が多いということになるのでしょう。

行列の積とニューラルネットワーク計算では、どちらも「掛け算したものの合計(足し算)」=積和演算が多用される。コンピューターアーキテクチャ的には、これを1命令で行う

融合積和演算(fused multiply-add; FMA)を実装することで誤差(精度落ち)を減らすことができる。

Copilot+PCにおけるNPUは、基本的には8ビット整数演算のみを要求することで小型化しているようですが、これは言い換えると推論だけを考えていることを意味します。少なくとも2017年段階で、推論は8ビット整数など低精度でも性能の低下は僅かで十分である一方、学習は32ビット浮動小数点でないとうまくいかないケースがたびたびあるため、安全をとって32ビットが選ばれることが多い、という状態でした。筆者はその手のアルゴリズムの専門家ではないのですが、最近の論文(Perez et al., 2023)でも、低ビット学習は学習できる幅が狭まるので、データが低ビット学習に向いているか検討するべき、ということになっているようです。

結局NPUでできることは電力を問わなければGPUでもできるわけで、GPUでできることをなぜあえてNPUを別に乗せなければならないのか、という疑問は生じます。普及型NPUの元祖といえるApple Neural Engineでは、スマホは電池持ちのためにチップ価格が上がっても電力を節約できるほうを選んだ、というあたりではないかと思います。

一方PCでは、NPUを使うWindows Studio Effectの同等機能がNPUなしでもZoomやTeamsで実現されていたように、電力や計算能力の余裕にものを言わせてCPUやGPUで実現してしまえる範囲ではあるため、特にiGPUが強化されている昨今、短期的にはNPUの必要性をあまり感じないのも事実です。可能性があるとするとメモリの扱い(メインメモリとVRAM)くらいですが、これも本格的に問題が顕在化・解決していくのは長期の話でしょう。

強引にCopilot+PCを推進するMicrosoft

最近数回繰り返し述べていますが、Copilotであれベンダー固有であれNPU動作するアプリは現在のところ数える程度しかありません。Copilot+PCはローンチパートナーのSnapdragon X Elite搭載機(Vivobook, Yoga Slim 7x)が最初からCocreator、Recall、Windows Studio Effect、ライブキャプション・翻訳、自動スーパー解像度がCopilot+PC特有の機能としてリストされていますが、その内訳を見ると「40 TOPSのNPUを生かせている」とは言い難い状況です。

まずRecallはセキュリティ上の懸念から10月(予定)に延期され記事執筆現在使えません。Cocreatorはインターネットへの接続が必要でローカル完結というNPUの利点を消してしまっています。Windows Studio Effect(カメラぼかし等)とライブキャプションは前回提示した「分類AI」に該当しスマホNPUでも十分動く軽いもので、実際前者はMeteor lakeやRyzen 7000シリーズなど10 TOPS級NPU搭載機ですでに動いています。

自動スーパー解像度はDLSS, FSR, XeSS相当の機能をQualcommの代わりにMicrosoftが実装したものとみなすことができ、これを「Copilot+PCの機能」というのは無理がありますし、そもそもWindows on ARMで例外的に動かないことが多いのがゲームであることを考えるとメリットは薄いと言わざるを得ません。

Microsoft肝いりのローンチパートナー製品すら40 TOPSのNPUを生かせておらず、Copilot+PCが「満足に動くアプリがないのにリリースされた」というのは否定できないところで、これでメーカーが「Copilot+PCにあらずんばPCにあらず」といわんばかりに殺到しているのは消費者からすると疑問を持たざるを得ません。

振り回されるチップベンダー

x86CPUへのNPUの搭載は昨年から始まっていますが、そこには特にソフトウェアとの関連で不可解な動きが見られます。

最初にNPUが付いたRyzen 7040は、発売時に「現状はWindows Studio Effectsのみで利用でき、AMDはRyzen AIを使うためのソフトウェア開発キットなどは提供していない」と、明白にMicrosoftのためだけに作っており、それ以外のアプリはそもそも作ることすらできない、と宣言しています。リフレッシュ版のRyzen 8040シリーズの発表時には「『新しいテクノロジを普及させるという課題には,ハードが先かソフトが先かという,鶏と卵のような関係がある』そしてAMDは,ハードウェアを先行させるという『困難な道を選択した』」等発言していますが、AMDが主体的に”困難な道”を選択する合理的理由はありません。そのRyzen 7040/8040シリーズはCopilot+PC非対応となり、消費者に無駄なコストを強いただけで終わるという残念な結果になりました。

次にCopilot+PC対応第1号として出されたHX 370は、PCメーカーが入手性が悪く価格が高いと文句を言っているという噂があり、実際記事執筆時現在でHPとLenovoからは1機種ずつ、Dellからは発売なしと3大メーカーがほとんど手を出さない状態で、Copilot+PCのために無理しすぎたという感があります(その苦労をおした現在Copilot+PC未認証状態、かつ認証されてもろくなアプリがない状態ですが……)。

Intelでも同様の混乱が見られます。昨年9月のIntel Innovation 2023のキーノートでは、Copilot(プラスではない無印)とIntel (というよりMeteor lake)が協動するかのようなスライドが存在していました。今年9月のLunar lakeの発表会ではこの態度は一転し、Copilot+PC対応にも関わらずそれを無視するかのような発表になり、むしろ独自のOpenVINOエコシステムがある自社製品くらいしかまともに動く消費者向けAIアプリはない、と主張する内容になっていま

す。

(上)Intel Innovation 2023でCopilotの旧ロゴを前面に出して”Our friend at Microsoft co-piloting this journey with us”(マイクロソフトにいる我々の友人がAI PCへの旅をナビしてくれる)と説明するゲルシンガーCEO

(下)2024年のLunar lake発表会でCopilot+PCを「応用の1例」程度の扱いでほぼ言及無しで済ますスライド(パネル左下部分)(クリックで拡大します)

また今年頭のCESで発表された2024春モデルでは、「Copilotキー」なるものの設置がメーカーに要請されており、「CESでは多くのPCメーカーが発表した2024年モデルに搭載されていた」という状態ですが、当然ながらこの時点で発表されていたPCは軒並みCopilot+PC非対応でした。

このあたりの動きを総合して邪推すれば、Microsoftはもともとスマホ同様の入出力フィルタ用に使える10 TOPS程度のNPUの搭載を考えており、その要請にIntelやAMDは(SDKなしと無理してでも)応じたものの、Bing等での生成AIの成果を受け強引に生成AI対応の40 TOPSを求めるようになり、AMDはRyzen 8040から半年後という無理なスケジュールをおし高コストを甘受してでもHX 370を発売し、Intelは当初18Aのお披露目と言われてたLunar lakeを急遽TSMC製にしてでも予定を繰り上げた――といったようなことがあったのではないかと想像してしまいます。

ローカルAIゴリ押しの理由

現在動くアプリの少なさから言えば、Copilot+PCの現状は「ゴリ押しされている」と言っても過言ではないとは思います。Microsoftがここまでやる動機を憶測すれば、いくつか挙げられます。

Microsoftはオンラインで利用可能なAIが好評で、Edgeのサイドバーにある文章生成やImage Creatorは私も良く使っていますが、サーバーサイドのAIは確実にサーバー代の負担を強います。Microsoftとすれば可能な限りユーザーのPCにこれをオフロードして費用を節約したいでしょう。

消費者サイドから見れば、サーバーサイドAIは情報を外部に送信しますし、それらはMicrosoft側に履歴や学習データとして保存される可能性があります。このため個人情報を含む文章を文章生成機能に放り込むのは躊躇せざるを得ません。(特にOfficeの主要顧客である企業に)安心して使ってもらうためにもAIのローカル実行はどこかで必要でしょう。

またAIフレームワークの主導権争いも考え得ます。githubの公式サンプルの利用者数では、NVIDIA CUDA (6.1k stars)が総合的に見てワントップ、学習用のGPUでAMDのROCm (4.5k stars)が追いすがり、推論ではIntelのOpenVINO (6.9k stars)が追いかけるといった情勢で、チップベンダー3強がエコシステムを握っている状態です。MicrosoftはDirectML (2.2k stars)は追いかける立場でONNX (17.7k stars)は推論専用かつ本格実用に至らない段階と、主導権は取れていません。陰謀論めいた憶測ですが、NVIDIAのCopilot+PC認証が最も後回しにされ、IntelやAMDがNPUで振り回されているのはそのあたりが理由で、Qualcommがパートナーになったのはその争いがないからだ――などの利害関係を想像してしまいます。

前回記事でも書いた通り、生成AIのローカル駆動はOffice製品を幅広く強化するポテンシャルがあり、生成AIのマネタイズに一番近い企業がMicrosoftであると私は考えています。その意味でMicrosoftが生成AIに賭けるのは納得しています。

しかし現状を見れば、消費者がろくに使えもしないNPUの抱き合わせをされ(ウエハ単価とNPUの面積から推察するに)数千円の支払い上乗せをさせられていることは紛れもない事実であり、その原因の一端がMicrosoftのCopilot+PC戦略にあることは明らかでしょう。手厳しい言い方をすれば、今のCopilot+PCは、”消費者の信用”という貯金を切り崩しながら続行されている状態であり、今のCopilot+PCの買い替えサイクルまでにまともなローカル実行アプリを出すことができなければむしろマイナスの効果になる背水の陣であることは、Microsoftにしっかり自覚してもらいたいとは思います。

関連リンク

CPU情報 記事一覧

H428’s channel:渋谷H YouTubeチャンネル

コメント

いつも感じるけど情報量、熱量が素晴らしい

ありがとうございます。調べられる限りは間違ったことを書かないようにする、というのを心掛けて書いております。

質問なのですが

Windows 11 24H2からNPU搭載PCはタスクマネージャーのリソースモニターでNPU使用率が表示されるようになったと聞きました

データセンターなどでのリースアップ品の映像出力端子無しのグラフィックボード(nvidia teslaやradeon instinct)などは

Windows側からNPUとして認識されるのでしょうか?

少なくともこちらのマニュアルではGPUとして認識されています。

https://learn.microsoft.com/ja-jp/azure/virtual-machines/windows/n-series-amd-driver-setup

これを変えるにはドライバ(というよりCUDAやROCm)などいろいろ触る必要があるので、NPU扱いになる可能性は低いと思います